حتی آسمان هم سقف آرزوهای دختر ایرانی نیست

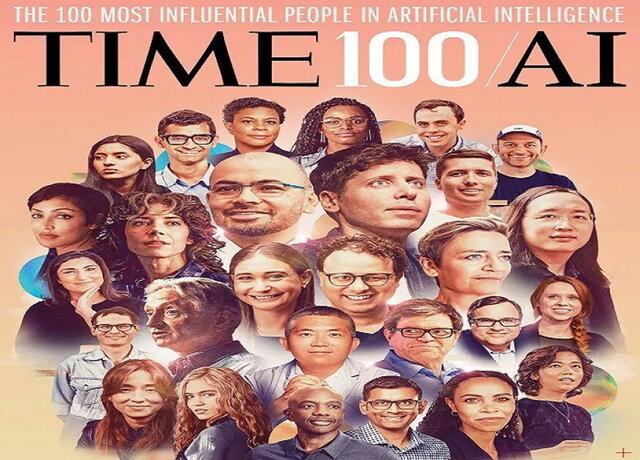

«الهام طبسی» پژوهشگر ارشد هوش مصنوعی که در ایران متولد شده و مدرک کارشناسی برق خود را از دانشگاه شریف دریافت کرده و در حال حاضر در موسسه ملی استاندارد و فناوری ایالات متحده مشغول کار است، از سوی مجله معتبر تایم به عنوان یکی از ۱۰۰ چهره برتر توسعه هوش مصنوعی برگزیده شده که در ادامه به مصاحبه وی با خبرنگار این مجله میپردازیم.

به گزارش ایسنا و به نقل از تایم، نزدیک به پنج سال پیش، موسسه ملی استاندارد و فناوری ایالات متحده(NIST) شروع به راهاندازی برنامهای برای پیشبرد توسعه سیستمهای هوش مصنوعی قابل اعتماد و مسئولیتپذیر کرد و این الهام طبسی، مهندس برق و رئیس کارکنان آزمایشگاه فناوری اطلاعات این مؤسسه بود که گفتوگوها حول تأثیر و خطر(ریسک) هوش مصنوعی را از اصول به اجرای عملی سیاستها انتقال داد.

پیشنهاد او به طور قابل توجهی نتیجه بخش بود. پس از شروع تحقیقاتِ تیم طبسی در مورد امنیت هوش مصنوعی و سوگیری آن، کنگره آمریکا موسسه ملی استاندارد و فناوری را که بخشی از وزارت بازرگانی این کشور است، موظف کرد تا چارچوب مدیریت خطر(ریسک) اختیاری را برای سیستمهای هوش مصنوعی قابل اعتماد به عنوان بخشی از قانون مجوز دفاع ملی(NDAA) در سال ۲۰۲۱ ایجاد کند.

طبسی به رهبری این تلاش ادامه داد و در ژانویه ۲۰۲۳ از چارچوب نهایی طراحی شده برای کمک به کاربران و توسعه دهندگان هوش مصنوعی در تحلیل و رسیدگی به خطرات مرتبط با سیستمهای هوش مصنوعی و در عین حال ارائه دستورالعملهای عملی برای رسیدگی و به حداقل رساندن چنین خطراتی، پردهبرداری کرد.

الهام طبسی که در دوران انقلاب و جنگ در ایران به دنیا آمده و بزرگ شده است، میگوید همیشه آرزوی دانشمند شدن را داشته است. او در سال ۱۹۹۴ برای تحصیلات تکمیلی خود به ایالات متحده مهاجرت کرد و پنج سال بعد در موسسه ملی استاندارد و فناوری(NIST) در پروژههای مختلف یادگیری ماشینی و بینش رایانهای با برنامههای کاربردی در ارزیابی بیومتریک و استانداردها شروع به کار کرد.

وی در اوایل کار خود، معمار اصلی کیفیت تصویر اثر انگشت(NFIQ) بود که اکنون یک استاندارد بینالمللی برای اندازهگیری کیفیت تصویر اثر انگشت است که توسط افبیآی و وزارت امنیت داخلی آمریکا به کار گرفته میشود.

اکنون به روایت مصاحبه این دانشمند ایرانی حاضر در فهرست ۱۰۰ فرد تاثیرگذار در توسعه هوش مصنوعی با مجله تایم میپردازیم؛

خبرنگار تایم: آیا میتوانید در مورد چارچوب مدیریت خطر هوش مصنوعی(RMF) و هدف از توسعهی آن به من بگویید؟ آیا این اولین چارچوب مدیریت خطر هوش مصنوعی است؟

الهام طبسی: این اولین چارچوب مدیریت خطر هوش مصنوعی ایجاد شده توسط موسسه ملی استاندارد و فناوری آمریکاست و یک بهروزرسانی برای موارد قبلی نیست. بنابراین هوش مصنوعی برای ما در موسسه ملی استاندارد و فناوری جدید نیست.

برنامه هوش مصنوعی قابل اعتماد و مسئولیتپذیر(Trustworthy Responsible AI) توسط موسسه ملی استاندارد و فناوری در سالهای ۲۰۱۸ تا ۲۰۱۹ پس از پیشرفت در یادگیری عمیق راهاندازی شد.

بسیاری از سازمانها و شرکتها در حال ساختن یک برنامه هوش مصنوعی هدفمندتر بودند و تلاشهای زیادی برای ایجاد هوش مصنوعی اخلاقی، مسئولیتپذیر و قابل اعتماد صورت گرفت.

"آیا آژانسها و سازمانها از زمان انتشار این چارچوب در ژانویه از آن استفاده کردهاند؟الهام طبسی: هر روز در مورد یک آژانس یا نهاد جدیدی که از آن استفاده میکند، میشنویم"بنابراین زمانی که ما در حال ساختن این برنامه بودیم، یک فرآیند رقابتی وجود داشت و چشماندازی که من ارائه دادم این بود که از اصول به عمل برویم و اجزای سازنده اصول سطح بالای قابل اعتماد، مسئولیتپذیری و اخلاقی را کشف کنیم.

ما تمام تلاشهای تحقیقاتی خود را برای توسعه چارچوب مدیریت خطر هوش مصنوعی انجام دادیم و فرآیندی باز، شفاف و فراگیر را راهاندازی کردیم و نه تنها با توسعهدهندگان فناوری، دانشمندان رایانه، ریاضیدانان، آماردانها و مهندسانی مانند خودم مشورت کردیم، بلکه به وکلای دادگستری، روانشناسان، جامعه شناسان، دانشمندان علوم شناختی و فیلسوفان نیز مراجعه کردیم. ما جلسات زیادی را برای بحث در مورد فناوری هوش مصنوعی، نحوه ساخت آن و همچنین افرادی که تحت تأثیر قرار میگیرند، برگزار کردیم و این موارد در توسعه برنامهمان بسیار مفید بودند.

خبرنگار: شما گفتید که این یک چارچوب اختیاری است و برای آژانسها و سازمانها در نظر گرفته شده است تا از آن برای تجزیه و تحلیل خطرات مرتبط با هوش مصنوعی استفاده کنند. آیا آژانسها و سازمانها از زمان انتشار این چارچوب در ژانویه از آن استفاده کردهاند؟

الهام طبسی: هر روز در مورد یک آژانس یا نهاد جدیدی که از آن استفاده میکند، میشنویم. ما واقعاً سازمانها را تشویق میکنیم تا به ما اطلاع دهند که چگونه از آن استفاده میکنند، زیرا سنجش اثربخشی این چارچوب، شخصاً برای من بسیار مهم است.

سنجش نحوه استفاده از یک ابزار داوطلبانه بسیار دشوار است، اما این یک موضوع درباره مسئولیتپذیری است. ما بیشتر و بیشتر از شرکتهایی که از آن استفاده میکنند - بسیاری از شرکتهای بزرگ – میشنویم.

من اجازه نام بردن از آنها را ندارم، اما بگذارید اینطور بیان کنیم که مایکروسافت طرحی را برای هوش مصنوعی مسئولیتپذیر و قابل اعتماد منتشر کرد که گفته بود از چاچوب هوش مصنوعی ما استفاده میکند. آنها گفتند که رویههای داخلی خود را هماهنگ کردهاند و از این چارچوب استفاده میکنند.

ما از سازمانهای دیگر و درون دولت نیز چنین چیزهایی شنیدهایم. بنابراین یکی از چیزهایی که در مورد چارچوب هوش مصنوعی ما وجود دارد این است که مخاطبان آن بسیار گسترده هستند. این چارچوب برای همه کسانی است که در حال طراحی، توسعه، استفاده و استقرار هوش مصنوعی هستند. بنابراین بخشهای مختلف و سازمانهای دولتی مختلف ایالات متحده نیز در مورد آن با ما همفکری میکنند یا با ما صحبت میکنند.

"ما بیشتر و بیشتر از شرکتهایی که از آن استفاده میکنند - بسیاری از شرکتهای بزرگ – میشنویم"به عنوان مثال، وزارت کار در حال ایجاد نمایهای از مدیریت خطر هوش مصنوعی است.

خبرنگار: بخش کلیدی این چارچوب این رویکرد مبتنی بر خطر است. ما بسیاری از بخشها را دیدهایم که این کار را انجام میدهند، اما به من بگویید چرا اتخاذ یک رویکرد مبتنی بر خطر برای هوش مصنوعی منطقی است؟

الهام طبسی: من فکر میکنم یک رویکرد مبتنی بر خطر برای بسیاری از بخشهای فناوری، از جمله هوش مصنوعی، منطقی است، زیرا هیچ رویکرد جامع و همه جانبه که برای همه موقعیتها مناسب باشد، وجود ندارد. بنابراین یک اقدام تجویزی، بسیار محدود کننده خواهد بود و مشکلات را حل نمیکند و برای هدف مناسب نیست. همچنین میتواند نوآوری را در نطفه خفه کند.

مثالی که من همیشه از آن استفاده میکنم این است که اگر از تشخیص چهره برای باز کردن قفل تلفن خود در مقابل تشخیص چهرهای که توسط مجریان قانون استفاده میشود، استفاده کنیم، میبینید که سطح خطر بسیار متفاوتی وجود دارد.

خبرنگار: بنابراین با این چارچوب، به نظر میرسد که موسسه ملی استاندارد و فناوری در تلاش برای حذف خطرات ناشی از هوش مصنوعی نیست، بلکه سعی میکند آن خطرات را شناسایی و مدیریت کند. درست است؟

طبسی: ما همیشه میگوییم که برای ما که در کار ساخت مدل و کار در علم و فناوری رایانه هستیم، هرگز خطای صفر وجود ندارد.

ما سعی کردهایم خطر را به حداقل برسانیم، اما نمیتوانیم سیستمهایی بسازیم که خطر صفر دارند. درعوض، آنچه باید انجام شود، درک خطرهای موجود، اولویتبندی آنها و درک تعاملات بین آنهاست.

یکی از کمکهای مهم چارچوب مدیریت خطر هوش مصنوعی این بود که ساختاری برای گفتگوهای مربوط به خطر هوش مصنوعی و مدیریت آن ارائه میدهد و نوعی واژگان قابل بحث برای صحبت در مورد آن ارائه میدهد. هر نهادی باید خطرپذیری خود را بداند، خطرهای موجود را درک کند، مبادلات و تعاملات بین آنها را تفسیر کند و راه حلی ارائه دهد.

خبرنگار: ایالات متحده مجموعهای رسمی از قوانین برای نحوه تنظیم هوش مصنوعی در بخش خصوصی ندارد. در همین حال اتحادیه اروپا در حال حاضر در حال کار بر روی آن است. شما گامهای بعدی در وضع مقررات برای هوش مصنوعی در اینجا در ایالات متحده را چه میدانید؟

طبسی: ما قطعاً باید استحکام فنی را به وجود آوریم تا قوانینی داشته باشیم که قابل اجرا و شفاف باشند.

"من اجازه نام بردن از آنها را ندارم، اما بگذارید اینطور بیان کنیم که مایکروسافت طرحی را برای هوش مصنوعی مسئولیتپذیر و قابل اعتماد منتشر کرد که گفته بود از چاچوب هوش مصنوعی ما استفاده میکند"به عنوان مثال، اگر میگوییم ایمنی هوش مصنوعی یا هوش مصنوعی پاسخگو، منظور از آنها واقعاً چیست؟

نظر شخصی من این است که مجموعه مناسبی از نردههای محافظ برای هوش مصنوعی، ترکیبی از رویکرد افقی و عمودی را در پیش خواهد گرفت که نوعی قابلیت همکاری و یکنواختی را برای درک، مدیریت و سنجش خطر در حوزههای مختلف به ارمغان میآورد. [یادداشت سردبیر: مقررات افقی برای همه برنامهها و بخشهای هوش مصنوعی اعمال میشود و معمولاً توسط دولت هدایت میشود، در حالی که مقررات عمودی فقط برای یک برنامه یا بخش خاصی از هوش مصنوعی اعمال میشود.]

اما تفاوتها یا نیازهای خاصی برای هر یک از موارد استفاده وجود دارد، به همین دلیل است که یک خط مشی عمودی یا استانداردهای اندازهگیری خاص مورد استفاده کمک کننده خواهد بود. من فکر میکنم که این یک رویکرد انعطافپذیرتر خواهد بود که امکان نوآوری را فراهم میکند.

امید من این است که هوش مصنوعی و همه این پیشرفتها واقعاً بتواند برخی از بزرگترین چالشهای زمانه ما را از پزشکی گرفته تا چالشهای آب و هوایی حل و فصل کند. من همیشه به دوستان و همکارانم میگویم که مراقبت از والدین سالخورده به اندازه مشاهده بزرگ شدن فرزندانمان رضایت بخش است. من پدر و مادرم را به دلیل یک بیماری نادر از دست دادم، پدرم را به دلیل سرطان از دست دادم، اما ما میتوانیم برای آن راه حل داشته باشیم.

خبرنگار: میدانم که ما در مورد چارچوب مدیریت خطر هوش مصنوعی زیاد صحبت کردیم، اما اکنون که این چارچوب عرضه شده است، روی چه چیز دیگری کار میکنید؟ آیا چیز جدیدی از دفتر شما در راه است؟

طبسی: یکی از چیزهایی که ما زمان زیادی را صرف آن میکنیم و در مورد آن بسیار هیجان زده هستیم، ارزیابی سیستمهای هوش مصنوعی است.

ما در حال ایجاد یک برنامه ارزیابی برای درک خطرات و تأثیرات هوش مصنوعی هستیم که هم به استحکام فنی و هم به جامعه و اینکه چگونه به نظر میرسد، نگاه داریم.

ما در عملیاتیسازی چارچوب خود به سازمانها و نهادها کمک میکنیم تا نمایههایی بسازند و در واقع شروع به استفاده از مدیریت خطر در حوزههای مختلف کنند.

ابتکار دیگری که در ماه ژوئن راهاندازی کردیم، توسعه یک نمایه میانبخشی چارچوب مدیریت خطر هوش مصنوعی برای مدیریت خطر سیستمهای هوش مصنوعی مولد بود. چارچوب مدیریت خطر هوش مصنوعی در ماه ژانویه منتشر شد و سپس ChatGPT ۳.۵ در نوامبر و ChatGPT ۴ در فوریه منتشر شد. اولین سوالی که ما داشتیم این بود که آیا چارچوب ما برای ChatGPT و هوش مصنوعی مولد قابل استفاده است یا خیر؟ پاسخ مثبت است.

بنابراین ما یک گروه کاری عمومی هوش مصنوعی مولد را راهاندازی کردیم تا راهنماییهای خاصی برای مدیریت خطر سیستمهای هوش مصنوعی مولد ایجاد کنیم. چیزی که اکنون به آن میپردازیم راهنمایی در مورد چگونگی انجام تأیید و اعتبار سنجی نسخه اولیه مدل است. بنابراین صحبتهای زیادی در مورد کاوش مضرات(Red-teaming) انجام می شود و تلاش میشود تا قدرت علمی و فنی به آن وارد شود.

"آنها گفتند که رویههای داخلی خود را هماهنگ کردهاند و از این چارچوب استفاده میکنند.ما از سازمانهای دیگر و درون دولت نیز چنین چیزهایی شنیدهایم"[کاوش مضرات فرآیندی برای آزمایش هوش مصنوعی برای یافتن نادرستیها و سوگیریهای موجود در آن است].

حوزهی دیگر، راهنمایی برای اصل و منبع محتوای دیجیتال است. بنابراین وقتی یک محتوا، تصویر یا متن را میبینید، چگونه میدانید که توسط هوش مصنوعی تولید شده است یا خیر؟ دو فعالیت دیگر در گروه کاری عمومی هوش مصنوعی مولد، حکمرانی است. ما معتقدیم که حکمرانی واقعاً بسیار مهم است. هر مدیریت خطری با حکمرانی شروع میشود و به حکمرانی ختم میشود. سپس افشای حوادث و رویدادهاست که داشتن مجموعهای از حوادث و آسیبپذیریهاست که میتواند به گسترش دانش هوش مصنوعی، آسیبپذیریها و حوادث برای جامعه پژوهش و توسعهدهنده آن کمک کند.

خبرنگار: علم و فناوری، از جمله هوش مصنوعی به شکل سنتی تحت سلطه مردان است.

کنجکاوم بدانم به جوانان و به ویژه زنانی که میخواهند مانند شما وارد این نوع کار شوند، چه میگویید؟

طبسی: تمام دوران تحصیلم در دانشگاه و تحصیلات تکمیلی یکی از معدود دختران کلاس بودم. من به آنها چه بگویم؟ من به آنها میگویم که حتی آسمان هم سقف آرزو نیست. مهم فقط نقطهی شروع است. پس رویای بزرگ داشته باشید، به دنبال آنچه میخواهید بروید. من در ایران بزرگ شدم که همانطور که به شما گفتم، زمان و مکان عجیبی برای بزرگ شدن دختری علاقهمند به ریاضی و علوم بود.

پدرم همیشه به ما میگفت تا زمانی که بیشترین تلاش را بکنید و ثابت قدمی خود را حفظ کنید، هیچ چیز غیر ممکن نیست.

انتهای پیام

اخبار مرتبط

دیگر اخبار این روز

حق کپی © ۲۰۰۱-۲۰۲۴ - Sarkhat.com - درباره سرخط - آرشیو اخبار - جدول لیگ برتر ایران